4 Tugas Utama Apache Spark untuk Data Engineer

Apache Spark menjadi tools data engineer yang sering digunakan untuk berbagai keperluan pemrosesan data. Dengan kelebihan dan fitur-fitur canggih yang dimilikinya, setiap proses pengolahan data menjadi lebih efektif dan efisien. Oleh karena itu, bagi kalian yang tertarik menjadi data engineer, sebaiknya segera mempersiapkan diri untuk menguasai Apache Spark.

Lalu, apa saja yang bisa dilakukan tools data engineer satu ini? Dalam pembahasan berikut akan dijelaskan lebih detail empat tugas utama yang bisa diselesaikan dengan Apache Spark. Mulai dari batch processing hingga membuat model machine learning.

Penasaran bagaimana cara kerjanya? Yuk, simak pembahasan di bawah ini!

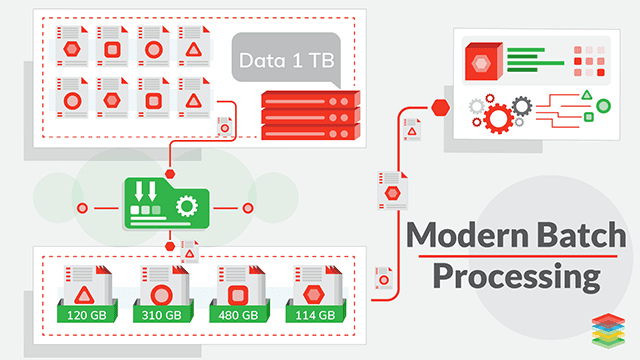

1. Batch Processing

Sumber gambar:.xenonstack.com

Batch processing adalah metode pemrosesan data di mana sejumlah data dikumpulkan, diproses, dan disimpan dalam blok waktu tertentu (batch). Dalam batch processing, data diambil dari sumbernya, kemudian diproses secara kolektif, dan hasilnya disimpan untuk analisis atau laporan lebih lanjut.

Proses ini dilakukan secara terjadwal dan biasanya tidak memerlukan respons secara real-time. Batch processing biasanya digunakan dalam pemrosesan gaji karyawan, laporan keuangan bulanan, atau analisis data historis.

Apache Spark adalah open-source yang dapat menangani pemrosesan batch dengan sangat efisien. Tools ini melakukan batch processing dengan menggunakan konsep pemrosesan paralel di mana data dibagi ke dalam sejumlah partisi dan diproses secara terdistribusi di beberapa node komputasi.

Keunggulan utama Apache Spark terletak pada kemampuannya untuk menyimpan data di memori (in-memory), sehingga pemrosesan data lebih cepat dibandingkan dengan sistem pemrosesan batch tradisional yang menyimpan data di disk.

Selain itu, Apache Spark menyediakan API yang mudah digunakan dalam bahasa pemrograman seperti Scala, Python, dan Java.

Baca juga : 3 Contoh Penerapan Data Science yang Sangat Berguna di Dunia Perindustrian

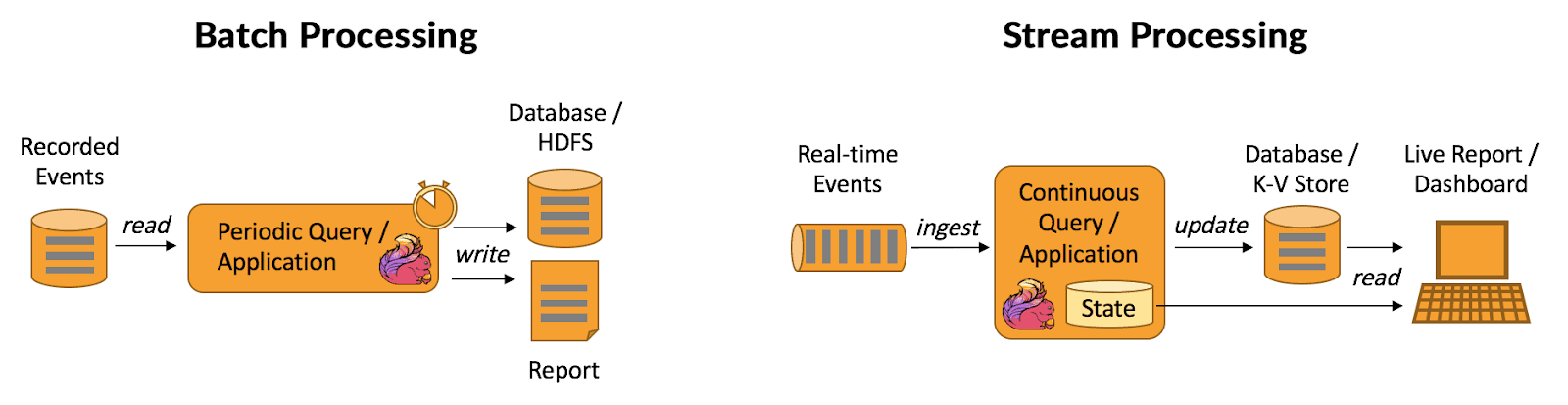

2. Stream Processing

Sumber gambar: k21academy.com

Stream processing adalah metode pemrosesan data yang mengolah data secara real-time. Dalam stream processing, data yang masuk diolah segera setelah data tersebut tersedia, tanpa menyimpannya terlebih dahulu ke dalam penyimpanan.

Cara ini sangat penting untuk proyek yang memerlukan respons cepat terhadap data real-time, seperti deteksi penipuan dalam transaksi keuangan, pemantauan jaringan, atau analisis data sensor pada perangkat IoT.

Nah, Apache Spark menyediakan modul Spark Streaming yang membantu data engineer untuk melakukan stream processing dengan mudah. Spark Streaming bekerja dengan mendekomposisi aliran data menjadi serangkaian batch kecil yang diperlakukan dengan cara yang mirip dengan pemrosesan data massal (batch processing).

Setiap batch kecil dari data streaming ini diolah menggunakan operasi transformasi seperti map, reduce, dan windowed aggregations. Apache Spark memastikan toleransi kesalahan dan daya tahan melalui replikasi data dan pemrosesan yang terdistribusi.

Data engineer yang menggunakan Apache Spark dalam stream processing memiliki beberapa tugas utama. Pertama, harus memahami sumber data streaming dan mengkonfigurasi Spark Streaming untuk menerima dan mengelola aliran data tersebut.

Selanjutnya, membangun operasi transformasi yang sesuai untuk menganalisis data real-time dan menghasilkan output yang relevan. Data engineer juga bertanggung jawab untuk memonitor kinerja aplikasi stream processing, memastikan bahwa proses berjalan dengan lancar, dan menangani error jika ada.

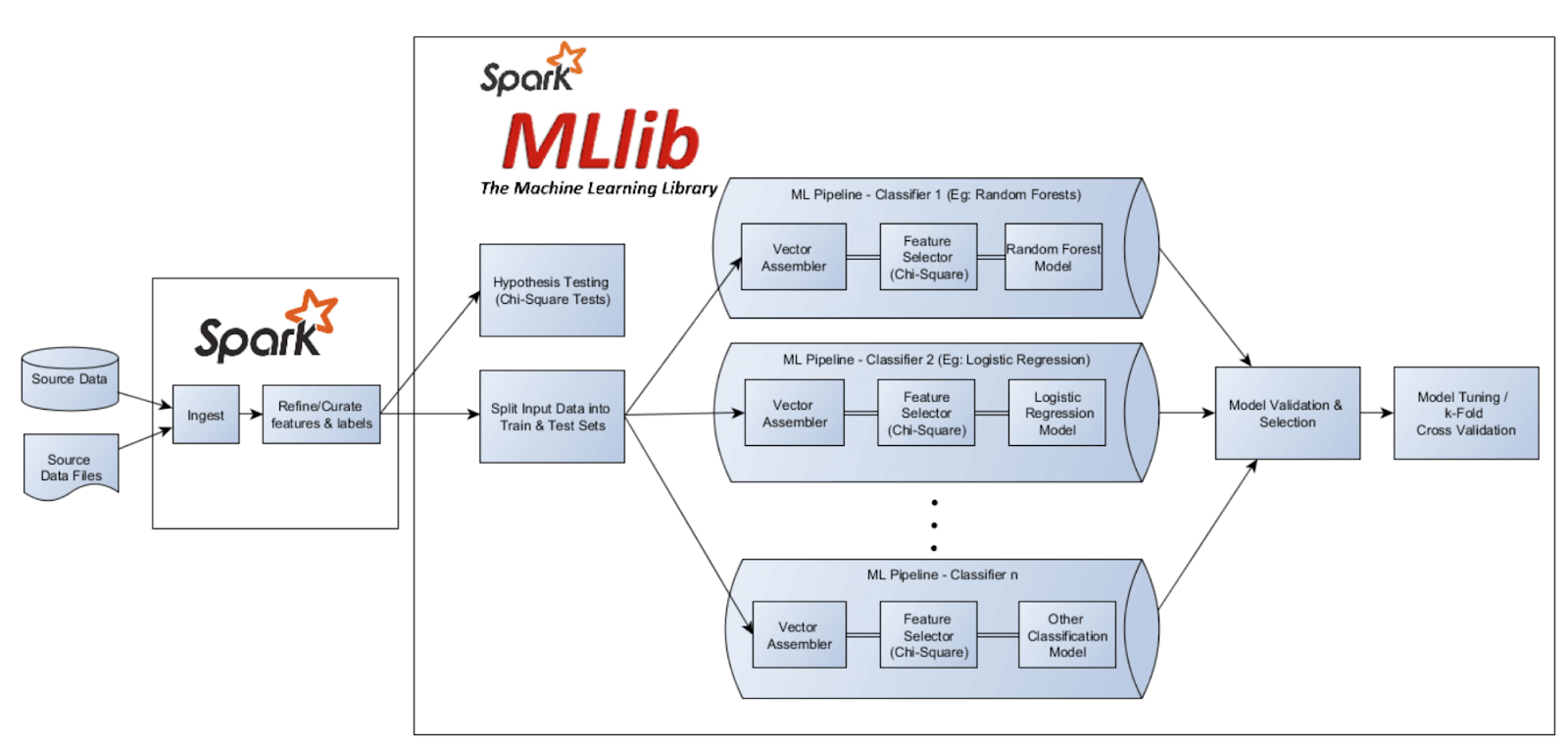

3. Machine Learning

Sumber gambar: qubole.com

Apache Spark menyediakan modul MLlib dan ML yang membantu data engineer untuk membangun, melatih, dan mengevaluasi model machine learning dengan data besar secara terdistribusi.

Tugas utama seorang data engineer meliputi pemilihan model yang sesuai untuk tugas tertentu, pengelolaan fitur-fitur data, serta melatih dan mengoptimalkan model menggunakan algoritma paralel yang mendukung Apache Spark.

Selain itu, data engineer juga bertanggung jawab untuk memastikan bahwa data yang digunakan untuk melatih machine learning berkualitas tinggi. Langkah ini melibatkan pemrosesan data pra-pembelajaran (pre-processing) seperti penanganan nilai-nilai yang hilang, normalisasi, dan transformasi fitur agar data siap digunakan.

Data engineer juga harus memahami teknik-teknik validasi model seperti validasi silang (cross-validation) dan membagi data (data splitting) untuk menghindari overfitting.

Baca juga : Data Science Adalah: Yuk Kenali Lebih Jauh Tentang Data Science!

4. Penyimpanan Data

Apache Spark mendukung beberapa sumber data yang berbeda, termasuk penyimpanan berbasis file seperti Hadoop Distributed File System (HDFS), penyimpanan data berbasis kolom seperti Apache Parquet, dan penyimpanan berbasis kolom terdistribusi lainnya.

Data engineer harus memahami karakteristik masing-masing penyimpanan data ini dan memilih yang paling sesuai dengan kebutuhan. Selain itu, juga mendesain skema data yang optimal untuk memastikan kinerja dan efisiensi dalam pengolahan data.

Selain itu, data engineer juga bertanggung jawab untuk mengoptimalkan penyimpanan data menggunakan Apache Spark. Hal ini melibatkan pengaturan partisi data dengan bijak, memastikan bahwa data terdistribusi secara merata di seluruh cluster, dan menggunakan teknik kompresi data untuk mengurangi kebutuhan ruang penyimpanan.

Data engineer juga harus memahami konsep caching di Apache Spark, yang memungkinkan data disimpan di memori untuk akses yang lebih cepat.

Ingin bisa mahir menggunakan Apache Spark dan menjadi praktisi data engineer profesional? Persiapkan diri kalian sekarang dengan belajar di DQLab! Modul ajarnya lengkap dan bervariasi. Bahkan diintegrasikan dengan ChatGPT. Manfaatnya apa?

Membantu kalian menjelaskan lebih detail code yang sedang dipelajari

Membantu menemukan code yang salah atau tidak sesuai

Memberikan solusi atas problem yang dihadapi pada code

Membantu kalian belajar kapanpun dan dimanapun

Selain itu, DQLab juga menggunakan metode HERO yaitu Hands-On, Experiential Learning & Outcome-based, yang dirancang ramah untuk pemula. Tunggu apa lagi, segera Sign Up dan siapkan diri menjadi data engineer andal!

Penulis : Dita Feby

Editor : Annissa Widya

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini