5 Fakta Dimensionality Reduction Algoritma Data Science

Data science menghadirkan banyak sekali algoritma yang bisa dipilih sesuai kebutuhan analis. Ada algoritma data science yang berfokus pada aspek klasifikasi data, seperti Decision Trees, Random Forests, Support Vector Machines (SVM), k-Nearest Neighbors (k-NN), Naive Bayes, dan Logistic Regression. Ada juga algoritma yang berfokus pada text mining dan lain-lain. Setiap algoritma memiliki kelebihan dan kelemahan tertentu tergantung pada jenis data dan masalah klasifikasi yang dihadapi.

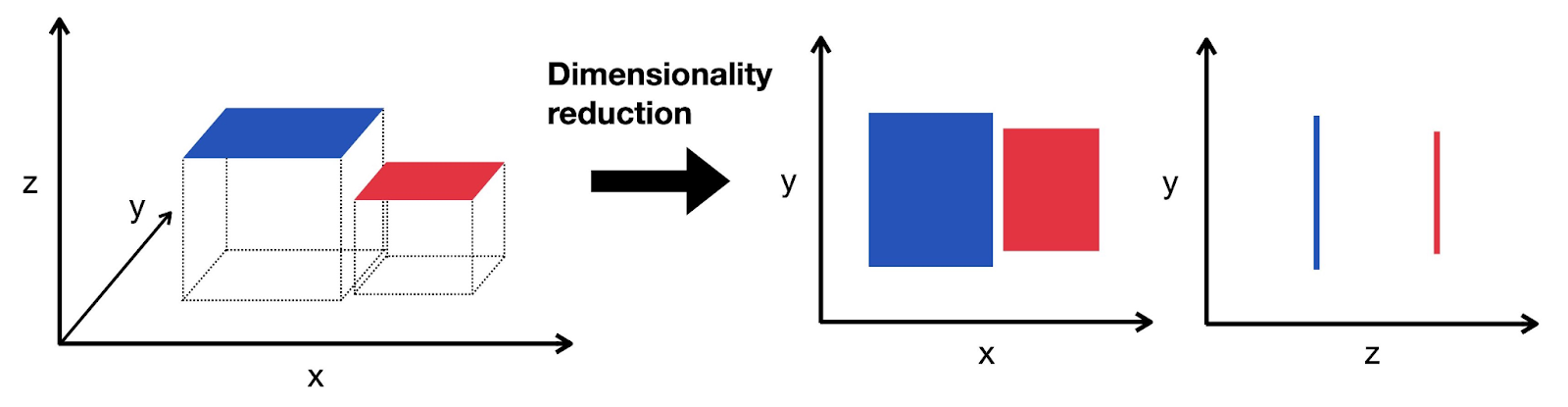

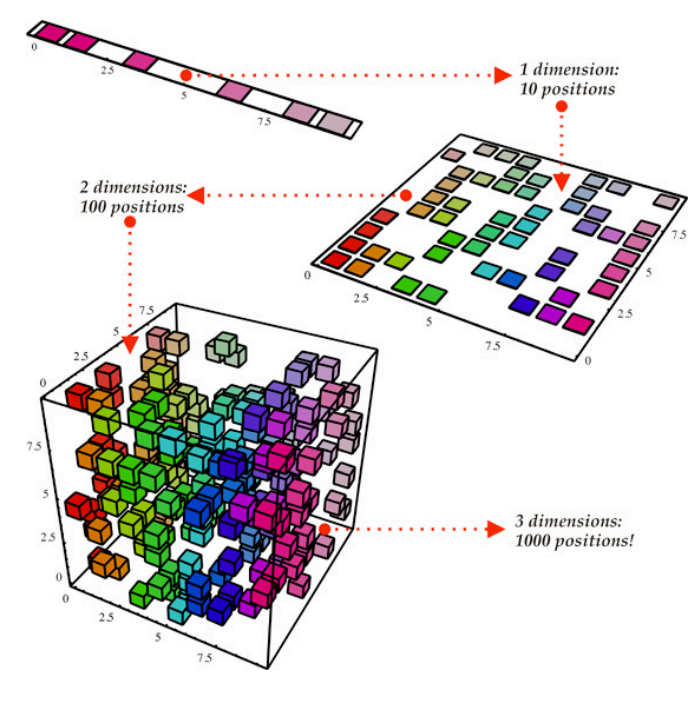

Namun, salah satu tantangan utama dalam analisis data adalah dimensi tinggi dari dataset yang dapat menyebabkan kompleksitas yang berlebihan dan penurunan kinerja model. Itulah mengapa Dimensionality Reduction menjadi kunci dalam mempersiapkan data sebelum memilih dan menerapkan algoritma klasifikasi tertentu. Dengan mengurangi dimensi data, algoritma klasifikasi dapat bekerja lebih efisien dan efektif, menghasilkan model yang lebih baik dalam memprediksi dan mengklasifikasikan data.

Dimensionality Reduction merupakan strategi yang penting dalam pengolahan data yang bertujuan untuk menyederhanakan representasi data tanpa kehilangan informasi penting. Dengan mengurangi dimensi atau fitur-fitur yang tidak relevan atau redundan, Dimensionality Reduction membantu mengatasi masalah high dimensionality yang seringkali terjadi dalam dataset modern.

Teknik ini dapat diterapkan baik pada data numerik maupun kategorikal, dan dapat meningkatkan efisiensi dan interpretabilitas model klasifikasi. Jika kamu terpikirkan untuk menggunakan algoritma data science yang satu ini, jangan skip artikel ini. Simak 5 faktanya yuk sahabat DQLab!

1. Menangani Masalah Multikolinearitas

Masalah multikolinieritas terjadi ketika dua atau lebih variabel dalam dataset saling berkorelasi. Ini dapat menyebabkan masalah dalam estimasi parameter model dan menurunkan kinerja model klasifikasi. Dengan mengurangi dimensi data, kita dapat mengurangi kemungkinan terjadinya multikolinieritas, karena hanya fitur-fitur yang paling informatif yang dipertahankan, sementara fitur yang redundan atau berkorelasi tinggi dihilangkan.

Baca juga : Data Science Adalah: Yuk Kenali Lebih Jauh Tentang Data Science!

2. Reduksi Overfitting

Salah satu manfaat utama Dimensionality Reduction adalah kemampuannya untuk mengurangi risiko overfitting dalam model klasifikasi. Overfitting terjadi ketika model terlalu kompleks dan 'menghafal' data pelatihan tanpa mampu menggeneralisasi pola yang relevan untuk data uji.

Dengan mengurangi dimensi data, misalnya dengan menggunakan teknik seperti Principal Component Analysis (PCA) atau t-distributed Stochastic Neighbor Embedding (t-SNE), kita dapat mengurangi jumlah parameter yang digunakan dalam model, sehingga mengurangi risiko overfitting.

Sumber: Single-cell best practices

3. Memperbaiki Kinerja Model

Dengan mengurangi dimensi data, algoritma klasifikasi cenderung dapat bekerja lebih efisien dan efektif. Model yang dibangun dengan dimensi yang lebih rendah cenderung memiliki waktu pelatihan yang lebih cepat dan membutuhkan lebih sedikit sumber daya komputasi. Selain itu, dengan mempertahankan sebagian besar informasi penting dari data asli, model yang didasarkan pada dimensi yang lebih rendah seringkali memiliki kinerja prediksi yang lebih baik.

Baca juga : 3 Contoh Penerapan Data Science yang Sangat Berguna di Dunia Perindustrian

4. Interpretabilitas Model Klasifikasi yang Lebih Baik

Dengan mengurangi dimensi data, kita seringkali dapat meningkatkan interpretabilitas model klasifikasi. Model yang dibangun dengan fitur-fitur yang lebih sedikit menjadi lebih mudah dipahami dan diinterpretasikan oleh manusia. Ini memungkinkan praktisi data science untuk mendapatkan wawasan yang lebih dalam tentang faktor-faktor yang mempengaruhi prediksi model dan membuat keputusan yang lebih informan berdasarkan hasil tersebut.

Sumber: Raft LLC

5. Identifikasi Fitur yang Penting

Meskipun tujuan utama Dimensionality Reduction adalah mengurangi dimensi data, seringkali juga dapat membantu dalam mengidentifikasi fitur yang paling penting atau informatif dalam dataset. Melalui teknik seperti feature selection dalam PCA, kita dapat memahami kontribusi relatif setiap fitur terhadap varian dalam data, membantu pemahaman kita tentang struktur data dan memungkinkan fokus pada fitur-fitur yang paling berarti.

Dalam kesimpulannya, Dimensionality Reduction adalah algoritma penting dalam data science klasifikasi yang memungkinkan adanya pengurangan kompleksitas data, meningkatkan kinerja model, dan memfasilitasi interpretasi yang lebih baik. Dengan penerapan teknik Dimensionality Reduction yang tepat, kita dapat menghasilkan model klasifikasi yang lebih efisien, efektif, dan mudah diinterpretasikan.

Jangan khawatir jika kamu pemula yang tidak memiliki background STEM karena gelar bukan halangan untuk menguasai ilmu data scientist agar bisa berkarir di industri 4.0. Buruan gabung bersama DQLab dengan Sign Up sekarang untuk #MulaiBelajarData di DQLab:

Buat Akun Gratis dengan Signup di DQLab.id/signup

Selesaikan modulenya, dapatkan sertifikat & reward menarik dari DQLab

Subscribe DQLab.id untuk Akses Semua Module Premium!

Penulis: Reyvan Maulid

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini