Fault Tolerance dalam Apache Spark, Tools Data Engineer

Apache Spark merupakan salah satu tools populer bagi seorang data engineer untuk melakukan pengolahan big data. Platform ini menawarkan kemampuan distribusi dan paralelisme yang tinggi, sehingga memungkinkan untuk mengolah data dalam skala besar dengan cepat dan efisien. Selain itu, Apache Spark juga dilengkapi dengan berbagai library dan modul yang mendukung berbagai jenis analisis data, termasuk pemrosesan streaming, pembelajaran mesin, dan analisis grafik.

Keunggulan lain dari Apache Spark adalah kemampuannya untuk berintegrasi dengan berbagai sumber data yang berbeda, mulai dari sistem penyimpanan data seperti Hadoop HDFS, Cassandra, hingga streaming data dari Kafka atau Kinesis. Dengan fleksibilitas dan skalabilitasnya, Apache Spark menjadi pilihan utama bagi para data engineer dalam menghadapi tantangan pengolahan big data di era digital ini.

Dalam penggunaannya, Apache Spark ini memiliki banyak istilah. Salah satunya yaitu fault tolerance. Fault tolerance menggambarkan kemampuan sistem untuk tetap beroperasi secara normal meskipun terjadi kegagalan pada salah satu komponen atau bagian dari sistem tersebut. Dalam konteks Apache Spark, fault tolerance menjadi sangat penting karena memungkinkan proses komputasi untuk tetap berjalan bahkan jika terjadi kegagalan pada node atau komputer dalam kluster.

Sistem fault tolerance Spark didasarkan pada replikasi data dan rekam jejak tugas (task logs). Ketika sebuah tugas (task) dalam Spark gagal, sistem akan secara otomatis memulai kembali tugas tersebut di node yang berbeda dan menggunakan data yang telah direplikasi untuk menghindari kehilangan informasi atau hasil akhir dari komputasi yang sudah dilakukan sebelumnya.

Dengan adanya fault tolerance, Apache Spark dapat diandalkan oleh data engineer dalam menangani aplikasi pengolahan data yang besar dan kritis. Kali ini, DQLab akan membahas lebih lanjut soal fault tolerance yang ada dalam Apache Spark. Simak ulasannya yuk!

1. Apa itu Fault Tolerance?

Fault tolerance merujuk pada kemampuan sistem untuk tetap beroperasi dengan baik ketika terjadi kegagalan dalam komponen atau sumber daya sistem. Dalam konteks pemrosesan data, ini berarti sistem harus dapat menangani kegagalan perangkat keras, kegagalan jaringan, atau kegagalan perangkat lunak dengan cara yang memungkinkan proses pengolahan data tetap berjalan tanpa kehilangan data atau hasil akhir yang benar.

Sumber Gambar: Medium.com/Sugandha Arora

Baca juga : Mengenal Data Engineer dan Prospek Karirnya

2. Kenapa Fault Tolerance Penting dalam Apache Spark?

Apache Spark dikembangkan dengan skala besar dan kinerja tinggi dalam pikiran. Ini dirancang untuk mengolah volume data yang besar dan kompleks dengan kecepatan yang tinggi. Dalam lingkungan seperti itu, kegagalan sistem dapat menjadi hal yang umum terjadi. Tanpa fault tolerance yang baik, kegagalan tersebut dapat menyebabkan kerugian data yang signifikan dan gangguan operasional yang serius.

3. Bagaimana Apache Spark Menerapkan Fault Tolerance?

Spark menggunakan model fault tolerance yang disebut "Resilient Distributed Dataset" atau RDD. RDD adalah kumpulan data yang terdistribusi di seluruh node dalam cluster Spark. Ini adalah abstraksi tingkat tinggi yang memungkinkan Spark untuk menyimpan data secara terdistribusi dan menjalankan operasi pemrosesan data di atasnya.

Baca juga : Data Engineer VS Data Scientist

4. Strategi Utama dalam Fault Tolerance Apache Spark

Ada beberapa strategi yang bisa diterapkan data engineer ketika ingin mengaplikasikan fault tolerance pada Apache Spark:

Rekomputasi: Salah satu strategi utama yang digunakan oleh Spark adalah rekomputasi. Ketika terjadi kegagalan pada suatu titik dalam proses komputasi, Spark dapat merekonstruksi hasilnya dengan menjalankan ulang operasi yang gagal pada bagian data yang hilang.

Logging dan Metadata: Spark menggunakan logging dan metadata untuk melacak setiap langkah operasi yang dilakukan pada RDD. Dengan cara ini, jika terjadi kegagalan, Spark dapat mengidentifikasi langkah-langkah yang telah dilakukan sebelumnya dan merekonstruksi kembali proses komputasi.

Replication: Beberapa operasi dalam Spark, seperti join dan group-by, melibatkan data yang dipecah menjadi bagian-bagian yang didistribusikan di seluruh node. Spark dapat menggandakan data ini di berbagai node untuk mengurangi risiko kehilangan data jika terjadi kegagalan pada salah satu node.

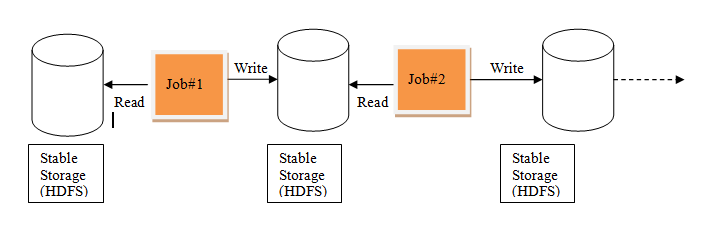

Checkpointing: Spark juga mendukung konsep checkpointing, di mana status RDD disimpan pada penyimpanan yang tahan lama seperti HDFS atau cloud storage. Ini memungkinkan Spark untuk memulihkan data dari titik tertentu dalam proses komputasi jika terjadi kegagalan.

Yuk, mulai belajar dan kuasai skill data scientist dari nol hingga advanced. Jangan khawatir jika kamu pemula yang tidak memiliki background STEM karena gelar bukan halangan untuk menguasai ilmu data analyst agar bisa berkarir di industri 4.0. Mulai bangun portfolio datamu yang outstanding dengan Data Analyst Career Track bersama DQLab dan nikmati modul-modul dari dasar hingga tingkat mahir.

Caranya dengan Sign Up sekarang untuk #MulaiBelajarData di DQLab:

Buat Akun Gratis dengan Signup di DQLab.id/signup

Selesaikan modulenya, dapatkan sertifikat & reward menarik dari DQLab

Subscribe DQLab.id untuk Akses Semua Module Premium!

Yuk langsung mulai perjalanan belajar data science sekarang bersama DQLab!

Penulis: Reyvan Maulid

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini