Komponen Kunci Pipeline ETL dalam Apache Spark

Apache Spark telah menjadi salah satu tools populer bagi seorang data engineer. Hal ini karena Apache Spark memiliki kemampuan dalam memproses data dengan cepat dan efisien. Salah satu aplikasi penting dalam Apache Spark adalah pipeline data ETL atau Extract, Transform, Load yang merupakan proses penting dalam manajemen data yang merupakan kunci dari pekerjaan data engineer.

Pipeline data ETL di Apache Spark adalah komponen penting untuk menangani big data. Pipeline ini terdiri dari empat komponen utama. Bersama-sama, komponen-komponen ini menyediakan kerangka kerja yang tangguh dan efisien untuk ekstraksi, transformasi, dan pemuatan data.

Artikel ini akan membahas komponen-komponen kunci dalam pipeline data ETL di Apache Spark yang dijalankan oleh data engineer dan bagaimana masing-masing berkontribusi pada proses keseluruhan. Simak penjelasannya yuk sahabat DQLab!

1. Spark Core sebagai Mesin Eksekusi Utama

Spark Core adalah mesin eksekusi utama di balik Apache Spark. Ini menyediakan sistem penjadwalan dan eksekusi tugas terdistribusi yang memungkinkan pemrosesan data secara paralel di seluruh cluster node komputasi. Keunggulan utama Spark Core adalah kemampuannya untuk mengelola dan mendistribusikan tugas-tugas secara efisien, yang sangat penting dalam lingkungan big data di mana volume data yang diproses sangat besar.

Dengan Spark Core, proses eksekusi dapat dipecah menjadi beberapa bagian yang dapat dijalankan secara simultan, meningkatkan kecepatan dan efisiensi pemrosesan data.

Baca juga : Mengenal Data Engineer dan Prospek Karirnya

2. Spark SQL untuk mendukung Pemrosesan Data secara Terstruktur

Spark SQL adalah modul dalam Apache Spark yang memungkinkan pemrosesan data terstruktur dan semi-terstruktur menggunakan kueri mirip SQL. Spark SQL memungkinkan pengembang untuk melakukan kueri data menggunakan sintaks SQL, yang memudahkan integrasi dengan sistem basis data tradisional.

Selain itu, Spark SQL menyediakan API untuk manipulasi data dalam beberapa bahasa pemrograman populer seperti Java, Scala, Python, dan R. Dengan menggunakan Spark SQL, pengguna dapat dengan mudah mengakses, memanipulasi, dan menganalisis data tanpa harus memahami kompleksitas pemrosesan data di balik layar.

3. MLib sebagai Perpustakaan Machine Learning

MLlib adalah perpustakaan pembelajaran mesin (ML) untuk Apache Spark yang menyediakan berbagai algoritma dan utilitas terdistribusi. Algoritma yang disediakan MLlib mencakup klasifikasi, regresi, clustering, dan penyaringan kolaboratif.

Keunggulan MLlib terletak pada kemampuannya untuk menangani dataset besar yang tidak dapat diolah dengan alat pembelajaran mesin tradisional. Dengan MLlib, pengguna dapat membangun model pembelajaran mesin yang skalabel dan efisien, memungkinkan analisis prediktif dan penerapan AI pada big data.

Sumber Gambar: Linkedin

Baca juga : Data Engineer VS Data Scientist

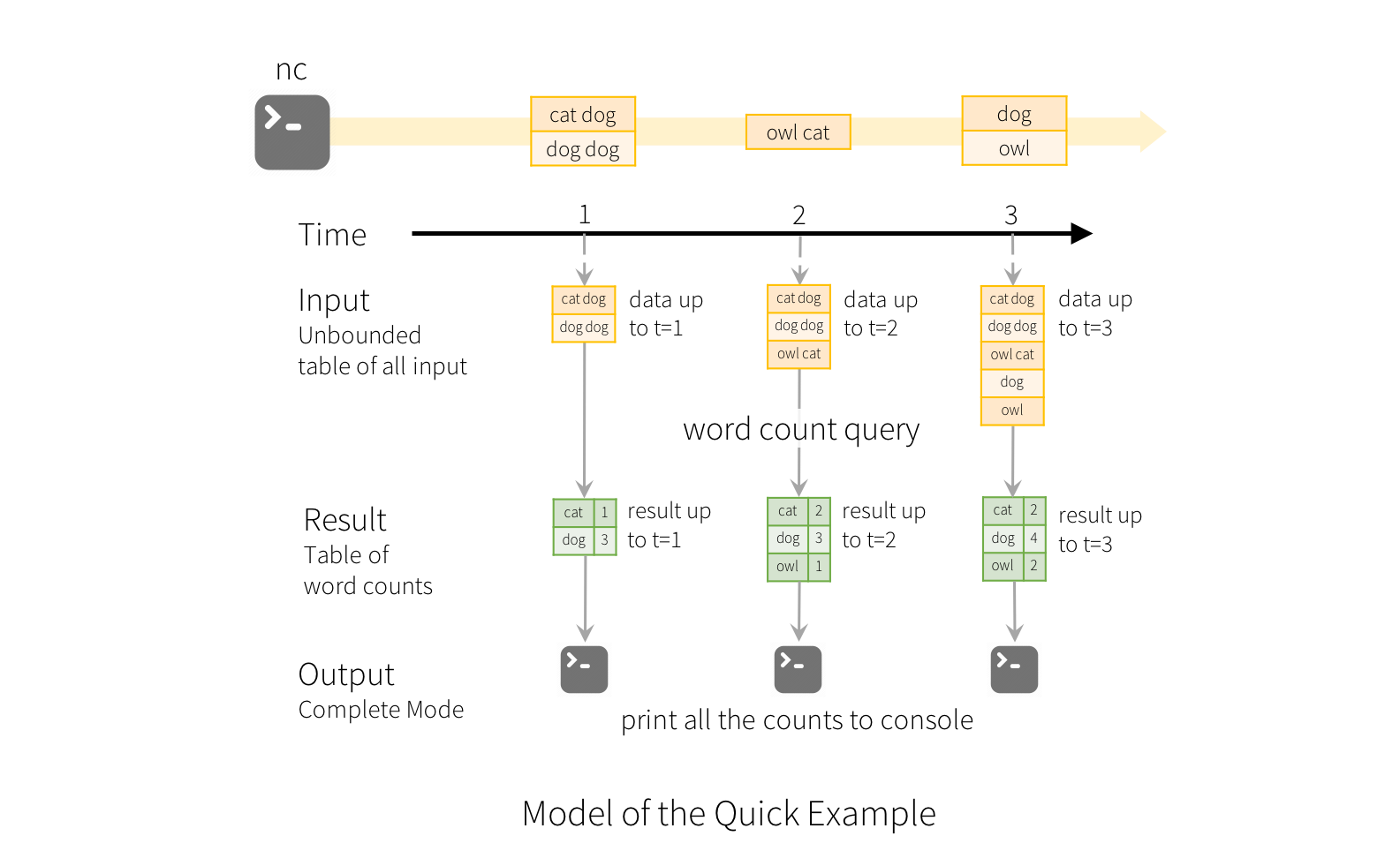

4. Structured Streaming untuk mendukung Pemrosesan Data secara Real-time

Structured Streaming adalah mesin pemrosesan data real-time yang memungkinkan pengguna untuk memproses data streaming dengan API tingkat tinggi yang sama seperti pemrosesan data batch. Ini berarti bahwa pengguna dapat menggunakan alat dan teknik yang sama untuk memproses data yang datang secara real-time maupun data yang sudah ada.

Structured Streaming dirancang untuk memberikan latensi rendah dan throughput tinggi, menjadikannya ideal untuk aplikasi yang memerlukan pemrosesan data secara terus menerus, seperti analisis log real-time, deteksi anomali, dan pemantauan sistem

Sumber Gambar: Apache Spark

Yuk, mulai belajar dan kuasai skill data scientist dari nol hingga advanced. Jangan khawatir jika kamu pemula yang tidak memiliki background STEM karena gelar bukan halangan untuk menguasai ilmu data analyst agar bisa berkarir di industri 4.0. Mulai bangun portfolio datamu yang outstanding dengan Data Analyst Career Track bersama DQLab dan nikmati modul-modul dari dasar hingga tingkat mahir.

Caranya dengan Sign Up sekarang untuk #MulaiBelajarData di DQLab:

Buat Akun Gratis dengan Signup di DQLab.id/signup

Selesaikan modulenya, dapatkan sertifikat & reward menarik dari DQLab

Subscribe DQLab.id untuk Akses Semua Module Premium!

Yuk langsung mulai perjalanan belajar data science sekarang bersama DQLab!

Penulis: Reyvan Maulid

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini