Peran Apache Spark untuk Data Engineer dalam ETL

Proses ETL (Extract, Transform, Load) kini menjadi proses yang krusial dalam mengelola data dengan efektif. ETL membantu mengumpulkan data dari berbagai sumber, mengubahnya menjadi format yang lebih berguna, dan memuatnya ke dalam sistem yang diinginkan. Salah satu alat yang semakin populer untuk menjalankan proses ETL adalah Apache Spark.

Apache Spark adalah framework open-source yang digunakan untuk pemrosesan data dalam skala besar. Dengan kecepatan tinggi dan kemampuan untuk memproses data secara paralel, Spark menjadi pilihan utama bagi banyak data engineer dalam menangani data yang kompleks dan besar.

Yuk, pelajari bersama bagaimana penggunaan Apache Spark untuk Data Engineer dalam proses ETL!

1. Mengenal Apache Spark untuk Data Engineer

Apache Spark adalah platform komputasi klaster yang dirancang untuk kecepatan dan kemudahan penggunaan. Spark mendukung berbagai bahasa pemrograman seperti Java, Scala, Python, dan R, dan dapat memproses data di memori, yang membuatnya jauh lebih cepat daripada teknologi tradisional yang bergantung pada disk. Spark pertama kali dikembangkan di AMPLab, University of California, Berkeley, dan kini dikelola oleh Apache Software Foundation.

Keunggulan utama Apache Spark bagi Data Engineer untuk melakukan proses ETL meliputi:

Dapat memproses data hingga 100 kali lebih cepat dalam memori dan 10 kali lebih cepat pada disk dibandingkan Hadoop MapReduce.

Dapat menangani data dalam skala yang lebih besar (skalabilitas), dari beberapa terabyte hingga petabyte.

Spark memiliki berbagai library seperti Spark SQL, MLlib untuk machine learning, GraphX untuk graf data, dan Structured Streaming untuk pemrosesan data real-time.

Baca juga : Data Engineer VS Data Scientist

2. Konsep ETL (Extract, Transform, Load)

ETL adalah proses yang digunakan untuk mengumpulkan data dari berbagai sumber, mengubah data tersebut menjadi format yang lebih sesuai, dan kemudian membuatnya ke dalam sistem tujuan. Berikut adalah penjelasan singkat tentang masing-masing tahap:

Extract: Mengambil data dari berbagai sumber, seperti database, file flat, API, atau layanan cloud.

Transform: Mengubah data menjadi format yang diinginkan, misalnya dengan membersihkan data, menggabungkan beberapa data set, atau melakukan agregasi.

Load: Memuat data yang telah diubah ke dalam sistem tujuan, seperti data warehouse, database, atau data lake.

ETL sangat penting dalam manajemen data karena membantu memastikan data yang digunakan dalam analisis atau aplikasi bisnis adalah data yang bersih, terstruktur, dan konsisten.

3. Langkah-langkah Implementasi Apache Spark untuk Proses ETL

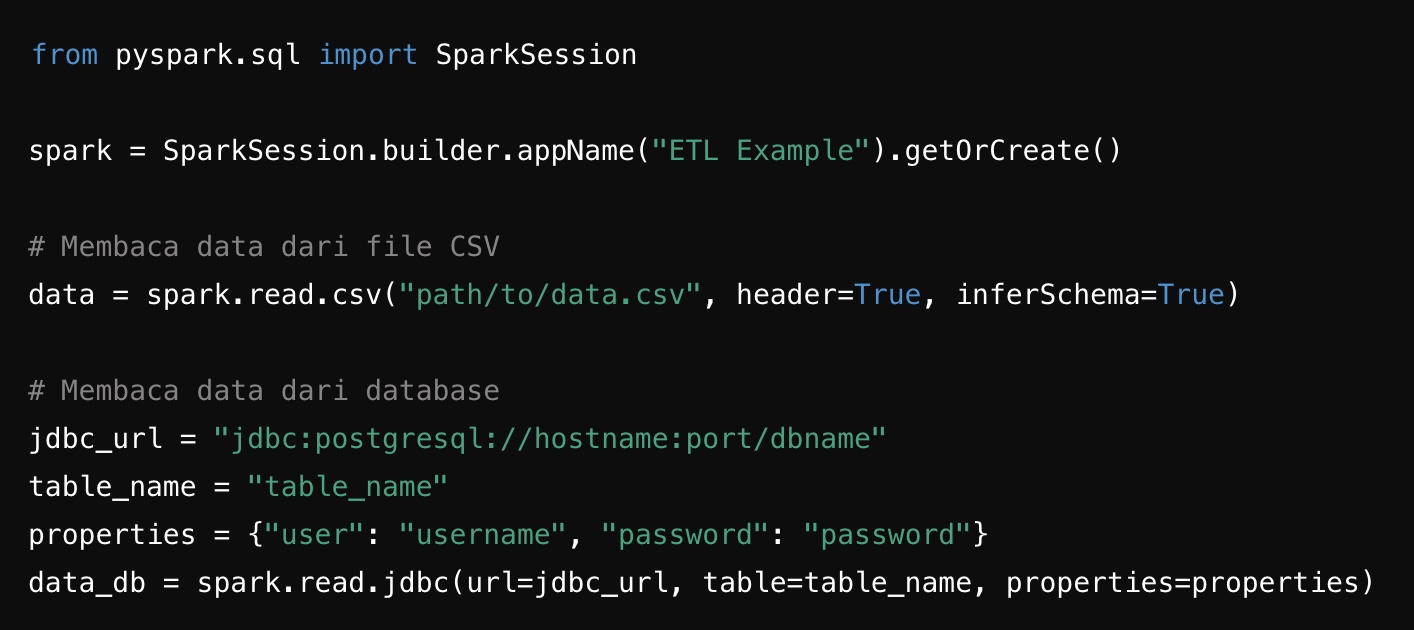

a. Extract (Mengambil Data)

Tahap pertama dalam proses ETL adalah mengumpulkan data dari berbagai sumber. Apache Spark menyediakan berbagai API untuk membaca data dari berbagai format dan sumber, seperti CSV, JSON, Parquet, dan bahkan database. Berikut contoh kode Python untuk mengambil data:

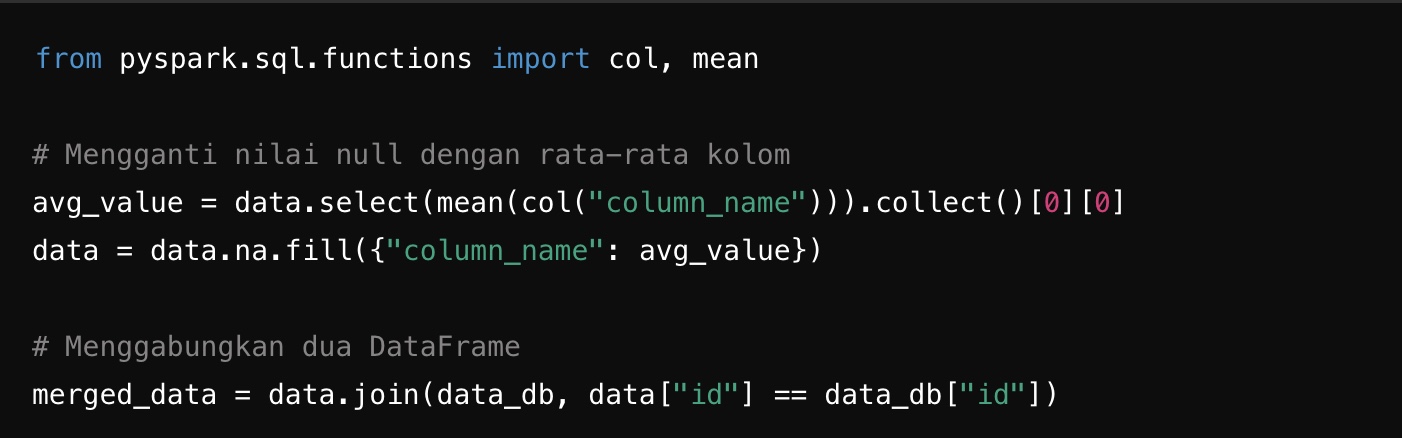

b. Transform (Mengubah Data)

Setelah data diambil, langkah berikutnya adalah mengubahnya sesuai kebutuhan. Transformasi bisa berupa pembersihan data, agregasi, penggabungan data dari berbagai sumber, dan lain-lain. contoh kode Python untuk mengubah data:

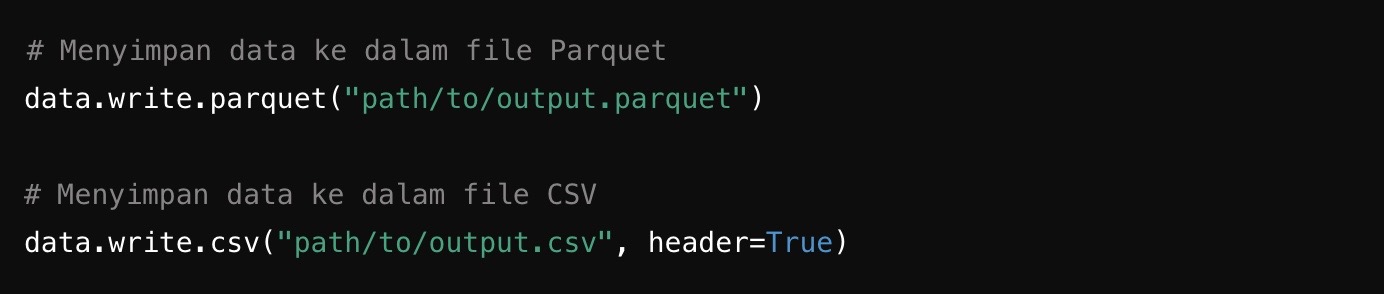

c. Load (Memuat Data)

Tahap terakhir dalam proses ETL adalah memuat data yang telah diubah ke dalam sistem tujuan. Spark mendukung berbagai format penyimpanan, termasuk file sistem, database, dan layanan cloud. Berikut adalah contoh kode Python untuk memuat data:

Baca juga : Mengenal Data Engineer dan Prospek Karirnya

Apache Spark menawarkan solusi yang kuat dan fleksibel untuk proses ETL, memungkinkan data engineer untuk menangani data modern dalam skala besar dengan efektif dan efisien, sehingga memberikan nilai lebih bagi organisasi atau perusahaan untuk mendukung pengambilan keputusan berbasis data yang lebih baik.

Gimana? Kamu tertarik untuk menguasai manajemen sistem database serta mengembangkan portofolio data yang outstanding untuk menjadi Data Engineer yang handal? Yuk, segera Sign Up ke DQLab! Disini kamu bisa banget belajar dengan modul berkualitas dan tools sesuai kebutuhan industri dari dasar hingga advanced meskipun kamu nggak punya background IT, lho. Dilengkapi studi kasus yang membantu para pemula belajar memecahkan masalah secara langsung dari berbagai industri.

Tidak cuma itu, DQLab juga sudah menerapkan metode pembelajaran HERO (Hands-On, Experiential Learning & Outcome-based) yang dirancang ramah untuk pemula, dan telah terbukti mencetak talenta unggulan yang sukses berkarier di bidang data. Jadi, mau tunggu apa lagi? Yuk, segera persiapkan diri dengan modul premium atau kamu juga bisa mengikuti Bootcamp Machine Learning and AI for Beginner sekarang juga!

Penulis: Lisya Zuliasyari

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini