Tools Data Engineer: Membuat Data Pipeline yang Efisien

Data Engineer adalah pahlawan di balik layar yang memastikan aliran data berjalan lancar dari satu titik ke titik lainnya. Data Engineer menggunakan berbagai tools untuk membangun dan mengelola data pipeline, sehingga data dapat diolah dan dianalisis dengan efisien. Tapi, apakah kamu tahu bagaimana cara membangun data pipeline yang efisien dan andal? Jangan khawatir, artikel ini akan memandu kamu langkah demi langkah, dengan bahasa yang sederhana dan mudah dipahami.

Membuat data pipeline mungkin terdengar rumit, tapi sebenarnya bisa dibuat lebih sederhana dengan perencanaan yang baik dan pemilihan tools yang tepat. Langkah-langkah berikut ini akan membantu kamu memahami prosesnya dari awal hingga akhir. Siap untuk memulai perjalanan menjadi Data Engineer yang handal? Yuk, kita mulai!

1. Perencanaan Data Pipeline

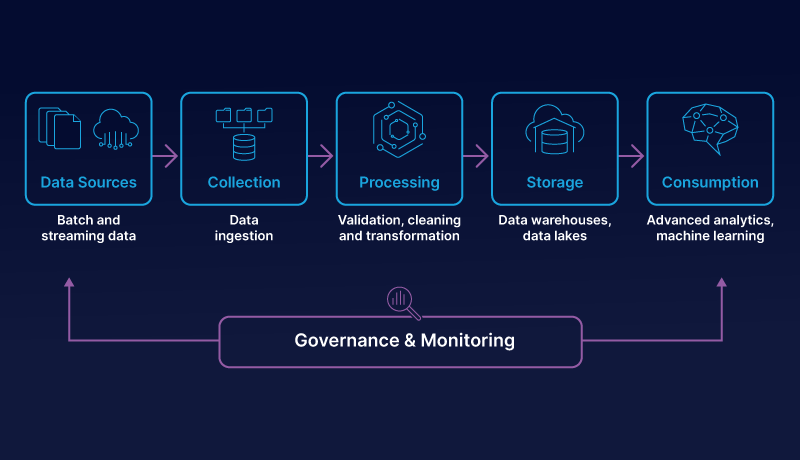

Langkah pertama adalah perencanaan. Tentukan tujuan dari data pipeline yang akan kamu buat. Apakah untuk mengumpulkan data dari berbagai sumber, membersihkan data, atau menyiapkannya untuk analisis? Dengan mengetahui tujuan ini, kamu bisa merencanakan alur kerja dan memilih tools yang tepat. Perencanaan yang matang akan menghemat banyak waktu dan tenaga di kemudian hari.

Baca juga : Mengenal Data Engineer dan Prospek Karirnya

2. Pemilihan Tools Data Engineer

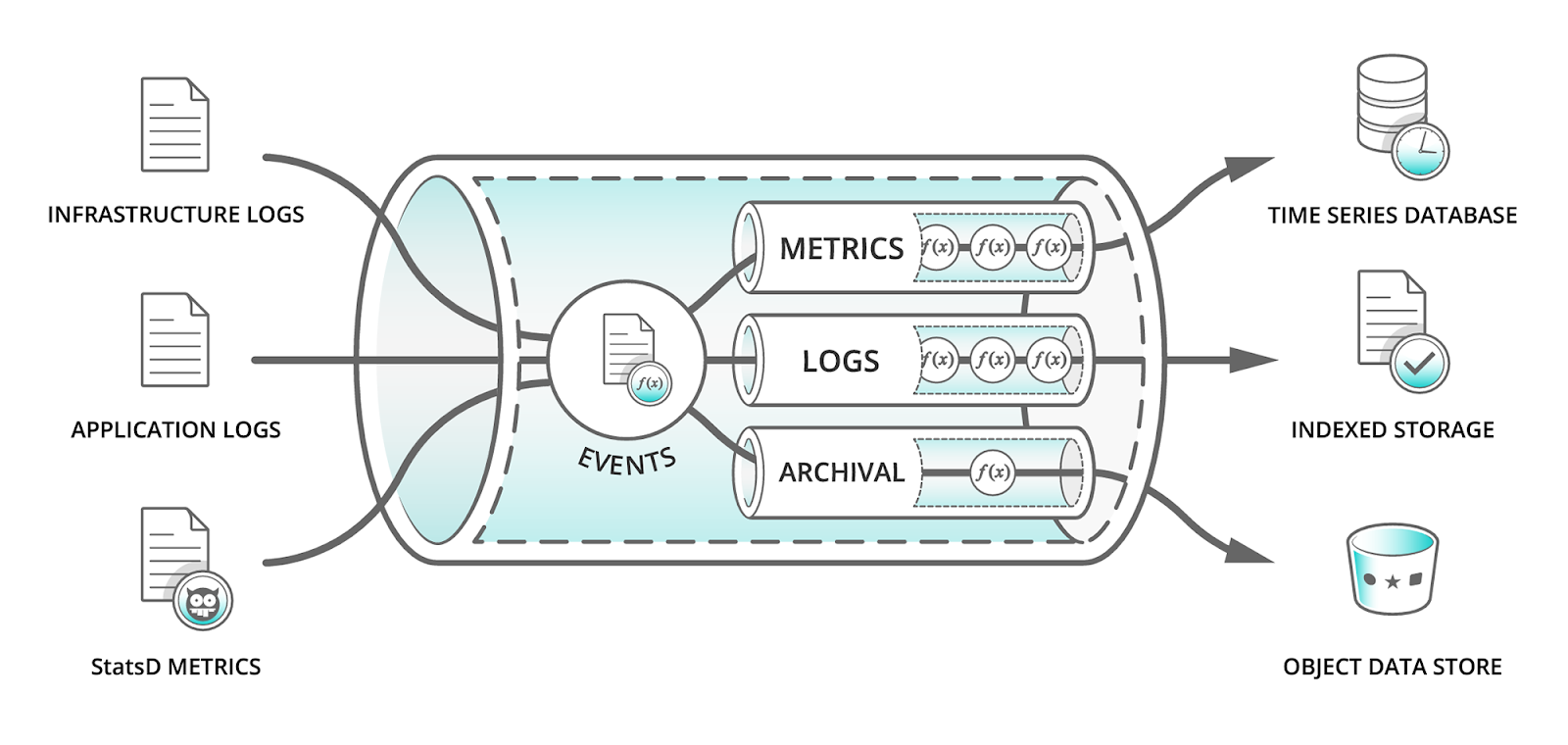

Setelah merencanakan, langkah berikutnya adalah memilih tools yang sesuai. Ada banyak tools data engineer yang tersedia, seperti Apache Kafka, Apache Airflow, dan Talend. Pilihlah tools yang sesuai dengan kebutuhan dan keahlianmu. Misalnya, Apache Kafka bagus untuk mengelola aliran data secara real-time, sedangkan Apache Airflow cocok untuk mengatur alur kerja data yang kompleks. Jangan ragu untuk mencoba beberapa tools sebelum memutuskan yang terbaik.

3. Implementasi Data Pipeline

Setelah tools dipilih, saatnya mengimplementasikan data pipeline. Mulailah dengan mengumpulkan data dari berbagai sumber. Kemudian, gunakan tools yang telah dipilih untuk mentransformasikan data tersebut, seperti membersihkan data yang tidak valid atau menggabungkan data dari berbagai sumber. Implementasi yang baik membutuhkan keterampilan coding, namun jangan khawatir, banyak tutorial online yang bisa membantu.

4. Pengujian dan Validasi

Langkah penting berikutnya adalah pengujian dan validasi data pipeline. Pastikan data yang diproses sudah sesuai dengan yang diharapkan. Uji setiap bagian dari pipeline untuk memastikan tidak ada kesalahan. Pengujian yang baik akan membantu menemukan dan memperbaiki bug sebelum data digunakan untuk analisis lebih lanjut. Validasi juga memastikan data yang dihasilkan akurat dan dapat diandalkan.

5. Pemeliharaan dan Monitoring

Setelah data pipeline berjalan, pemeliharaan dan monitoring rutin sangat penting. Pantau aliran data secara berkala untuk memastikan tidak ada hambatan. Gunakan tools monitoring untuk mendeteksi masalah lebih awal. Pemeliharaan rutin juga meliputi pembaruan software dan perbaikan bug. Dengan pemeliharaan yang baik, data pipeline akan terus berjalan dengan efisien dan andal.

Baca juga : Data Enginer VS Data Scientist

Data Engineer membutuhkan berbagai tools untuk menangani dan memproses data dalam skala besar dan kompleks. Masing-masing tools memiliki kelebihan dan kegunaan yang spesifik, sehingga memungkinkan Data Engineer untuk membangun, mengelola, dan mengoptimalkan pipeline data dengan efisien. Untuk menjadi seorang Data Engineer, kamu bisa mulai dengan mempelajari modul-modul Python, R, dan Tableau yang disediakan oleh DQLab.

DQLab merupakan platform belajar online yang berfokus pada pengenalan Data Science & Artificial Intelligence (AI) dengan menggunakan bahasa pemrograman populer, serta platform edukasi pertama yang mengintegrasi fitur Chat GPT. Selain itu DQLab juga menggunakan metode HERO yaitu Hands-On, Experiential Learning & Outcome-based, yang dirancang ramah untuk pemula.

Yuk sign up di DQLab untuk mendapatkan pengalaman belajar yang lebih menarik. Daftar sekarang dan kejar impianmu untuk menjadi Data Scientist!

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini