Tutorial Jalankan Skrip Python untuk Data Parquet

Dalam era data yang semakin berkembang, format penyimpanan data memainkan peran penting dalam pengelolaan dan analisis data. Salah satu format yang populer digunakan adalah Parquet, yang merupakan format kolumnar yang efisien untuk penyimpanan data dalam skala besar.

Parquet adalah format penyimpanan data kolumnar yang dikembangkan oleh Apache. Format ini dirancang untuk menyimpan data dalam bentuk kolom, yang membuatnya sangat efisien dalam hal penyimpanan dan performa akses data.

Python adalah salah satu bahasa pemrograman yang paling populer untuk analisis data. Dengan berbagai perpustakaan yang kuat, Python memudahkan proses pengelolaan dan analisis data dalam berbagai format, termasuk Parquet.

Parquet sering digunakan dalam ekosistem Hadoop dan telah menjadi standar de facto untuk penyimpanan data analitik besar di cloud dan sistem distribusi data lainnya. Dengan memahami cara kerja dan keuntungan dari format Parquet serta bagaimana memanfaatkannya dengan Python, kamu dapat meningkatkan efisiensi dan efektivitas dalam pengelolaan dan analisis data besar.

Artikel ini akan membahas tutorial menjalankan skrip Python dalam membaca data Parquet, serta mengapa format ini sangat menguntungkan untuk digunakan dalam berbagai aplikasi data. Simak informasi ini sampai habis ya sahabat DQLab!

1. Import Library dan Membaca File Parquet

Hal pertama yang kamu lakukan yaitu kamu perlu mengimpor pustaka yang diperlukan. Sebagai contoh, pada situasi ini kamu bisa mengimpor pustaka Pandas. Berikut adalah sintaksnya.

Kemudian, kamu bisa menggunakan fungsi read_parquet dari pandas untuk membaca file Parquet. Pastikan untuk mengganti "path/to/your/file.parquet" dengan jalur file Parquet yang ada pada laptop atau PC kamu.

Baca juga : Bootcamp Data Analyst with SQL and Python

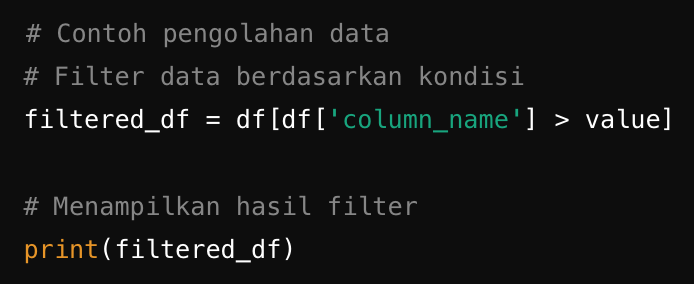

2. Mengolah Data

Setelah data di-load ke dalam DataFrame “pandas”, kamu bisa melakukan berbagai operasi data seperti filter, agregasi, dan sebagainya.

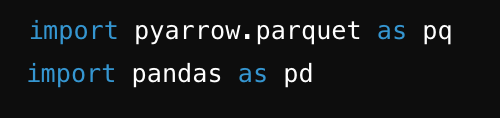

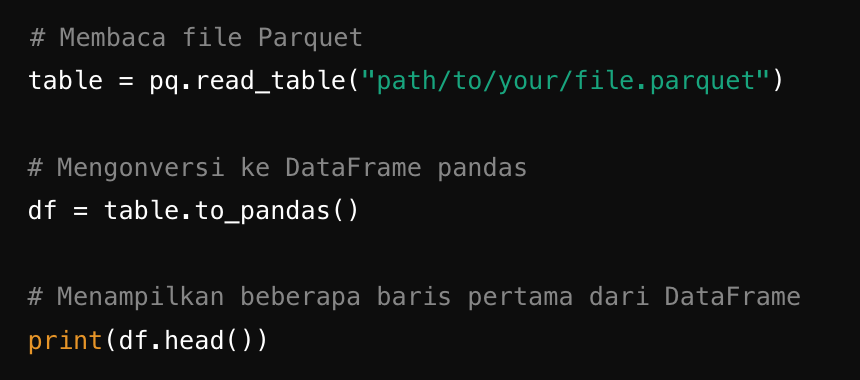

3. Menggunakan Pustaka PyArrow

Untuk mempermudah proses pembacaan file Parquet, kamu membutuhkan pustaka khusus yaitu pyarrow. pyarrow adalah pustaka Apache Arrow untuk Python yang mendukung berbagai operasi data kolumnar dan serialisasi yang sangat efisien.

Kita perlu mengimpor pustaka pyarrow dan pandas.

Kemudian kamu bisa menggunakan fungsi read_table dari pyarrow untuk membaca file Parquet dan mengkonversinya menjadi DataFrame pandas.

Baca juga : Mengenal Perbedaan R Python dan SQL

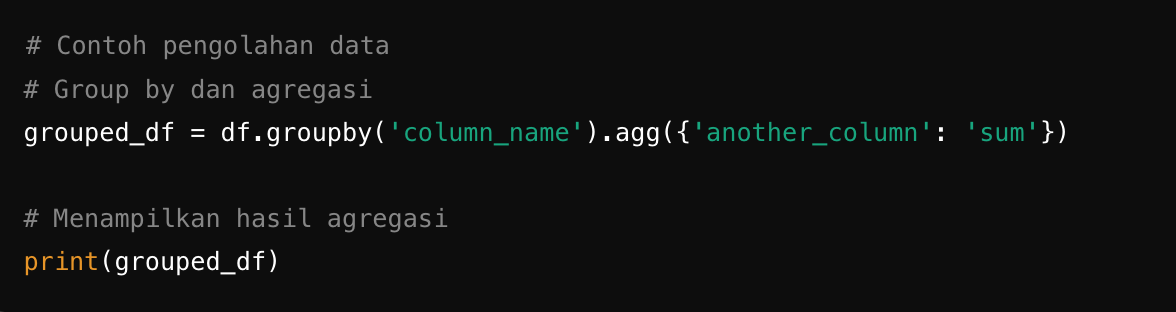

4. Olah data sesuai kebutuhan

Sesuai dengan sebelumnya, kamu bisa mengolah data sesuai dengan kebutuhan.

Penggunaan Python untuk membaca data Parquet menawarkan banyak keuntungan, terutama dalam hal efisiensi dan fleksibilitas pengolahan data. Dengan berbagai perpustakaan yang kuat dan dukungan ekosistem yang luas, Python memungkinkan para profesional data untuk dengan mudah mengakses, memproses, dan menganalisis data dalam format Parquet. Hal ini menjadikannya pilihan ideal untuk aplikasi big data dan analitik di era data modern saat ini.

Sekarang kamu jadi tahu kan istilah data parquet yang biasanya dipakai pada bahasa pemrograman Python? Kalau kamu penasaran lebih banyak lagi soal Python, kamu nggak perlu khawatir.

Kamu tetap bisa mengasah pemahaman mendasar kamu tentang python, kamu bisa bergabung dalam rangkaian modul DQLab yang berjudul “Python for Data Professional Beginner”. Modul ini terdiri dari 3 part yang bisa kamu selesaikan secara bertahap loh.

Caranya gimana? Mudah banget kok cukup signup sekarang ke DQLab.id lalu pilih menu learn. Setelah itu kamu sudah bisa menikmati pembelajaran yang praktis dan aplikatif dan jago machine learning bersama DQLab! Tunggu apa lagi? Yuk, signup sekarang dan mulai belajar Module Premium di DQLab atau ikuti Bootcamp Data Analyst with SQL and Python!

Penulis: Reyvan Maulid

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini