Tutorial Jalankan Skrip Python untuk Pengolahan Big Data

Di era digital ini, data semakin menjadi sesuatu hal yang sangat berharga dalam berbagai aspek kehidupan. Dari media sosial hingga perusahaan besar, semuanya menghasilkan data dalam jumlah yang sangat besar, yang sering disebut sebagai Big Data. Mengolah dan menganalisis Big Data ini penting untuk membantu perusahaan memahami pola, tren, dan bahkan membuat keputusan bisnis yang lebih baik.

Namun, bekerja dengan Big Data bukanlah hal yang mudah karena melibatkan volume data yang sangat besar dan kompleksitas tinggi. Untungnya, Python hadir sebagai salah satu bahasa pemrograman paling populer yang digunakan untuk menangani masalah ini. Mengapa Python? Sederhananya, Python memiliki berbagai pustaka (libraries) yang sangat kuat dan mudah digunakan, bahkan untuk pemula.

Penasaran bagaimana cara menjalankan skrip Python untuk mengelola Big Data? Yuk, pelajari selengkapnya melalui pembahasan berkut ini!

1. Kenapa Python Cocok untuk Big Data?

Banyak bahasa pemrograman bisa digunakan untuk mengolah Big Data, tapi Python menonjol karena beberapa alasan berikut:

Mudah Dipelajari dan Dipahami

Python terkenal dengan sintaksnya yang sederhana dan mudah dibaca. Ini membuatnya cocok bagi pemula yang baru belajar pemrograman, termasuk mereka yang ingin mengolah data dalam jumlah besar.Libraries yang Kuat

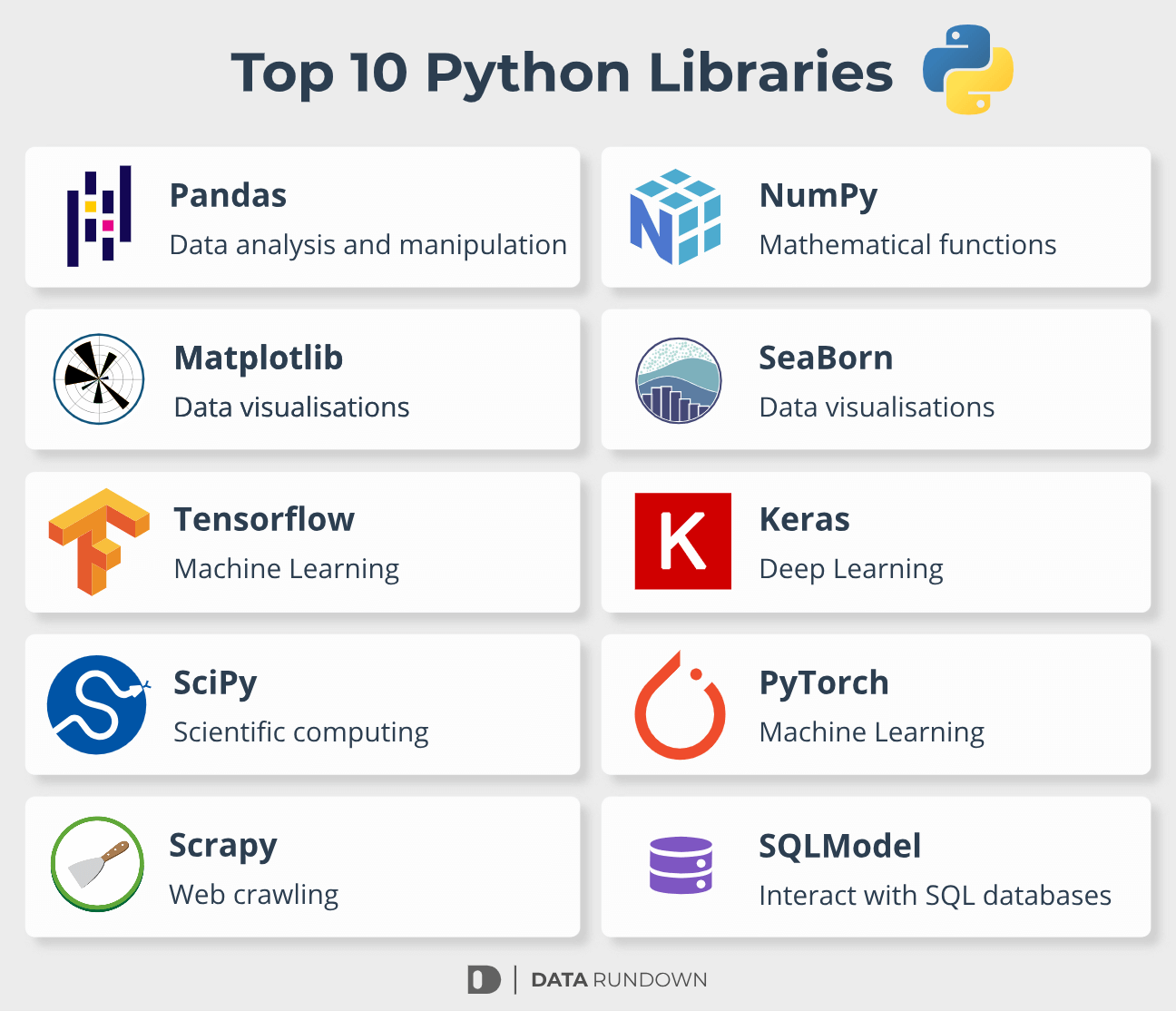

Python memiliki libraries yang sudah dirancang khusus untuk mengolah Big Data, seperti:

Pandas: untuk manipulasi data tabular (mirip dengan spreadsheet).

NumPy: untuk operasi numerik dan array multidimensi.

PySpark: versi Python dari Apache Spark, yang sangat populer untuk pemrosesan data besar secara parallel.

Dask: untuk parallel computing dan mampu menangani dataset yang lebih besar dari kapasitas RAM.

Sumber: Datarundown

Komunitas yang Aktif

Python memiliki komunitas pengguna dan pengembang yang sangat besar. Jika kamu menemui masalah, kemungkinan besar ada solusinya di internet, mulai dari forum diskusi hingga tutorial.Skalabilitas dan Performa

Meskipun Python terkenal sebagai bahasa yang lambat dibandingkan C++ atau Java, pustaka seperti PySpark memungkinkan Python untuk memproses data besar dengan cepat menggunakan distributed computing.

Dengan keunggulan-keunggulan ini, Python menjadi pilihan tepat untuk siapa saja yang ingin mulai mengolah Big Data, baik itu untuk proyek kuliah, pekerjaan, atau penelitian.

Baca juga : Mengenal Perbedaan R Python dan SQL

2. Persiapan: Instalasi dan Pengaturan Lingkungan Python

Sebelum kita mulai menulis skrip Python untuk mengolah Big Data, kamu perlu memastikan bahwa Python dan beberapa tools pendukung telah terinstal di komputer kamu. Jangan khawatir, prosesnya cukup mudah!

Instalasi Python Langkah pertama adalah memastikan kamu sudah menginstal Python di komputermu. Kamu bisa mengunduhnya dari situs resmi Python. Pastikan kamu memilih versi terbaru.

Menggunakan Anaconda atau Virtual Environment

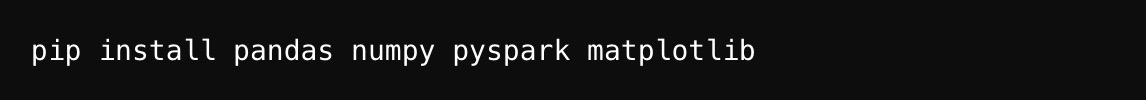

Agar pengelolaan libraries lebih mudah, terutama untuk pemrosesan data besar, banyak orang menggunakan Anaconda, sebuah distribusi Python yang dilengkapi dengan banyak tools data science. Kamu bisa mengunduh Anaconda dari situs resminya. Alternatif lainnya, kamu bisa menggunakan virtual environment bawaan Python untuk memastikan libraries yang kamu gunakan tidak bentrok dengan proyek lainnya.Instalasi Libraries Penting Setelah Python terpasang, langkah selanjutnya adalah menginstal beberapa libraries yang akan kita gunakan dalam tutorial ini:

Libraries ini akan membantu kamu dalam membaca, membersihkan, dan memvisualisasikan data.

Libraries ini akan membantu kamu dalam membaca, membersihkan, dan memvisualisasikan data.

Menggunakan Jupyter Notebook Untuk pengolahan data yang lebih interaktif, kamu bisa menggunakan Jupyter Notebook. Ini adalah interface berbasis web yang memungkinkan kamu menulis kode Python dan melihat hasilnya secara langsung. Kamu bisa menjalankannya dengan perintah berikut setelah menginstal Anaconda:

![]()

3. Langkah 1: Memahami Dataset yang Akan Diproses

Sebelum mulai menulis kode, sangat penting untuk memahami dataset yang akan kamu proses. Dalam dunia Big Data, ada dua jenis utama data:

Data Terstruktur: Data yang diorganisir dalam bentuk tabel atau spreadsheet, seperti file CSV atau database SQL.

Data Tidak Terstruktur: Data yang tidak memiliki format atau struktur tertentu, seperti teks, gambar, atau video.

Misalnya, dalam tutorial ini, kita akan menggunakan dataset terstruktur berupa file CSV besar yang berisi data penjualan suatu perusahaan. Tujuan kita adalah membersihkan data ini, melakukan beberapa analisis, dan menampilkan hasil dalam bentuk visualisasi.

4. Langkah 2: Membaca dan Membersihkan Data Menggunakan Python

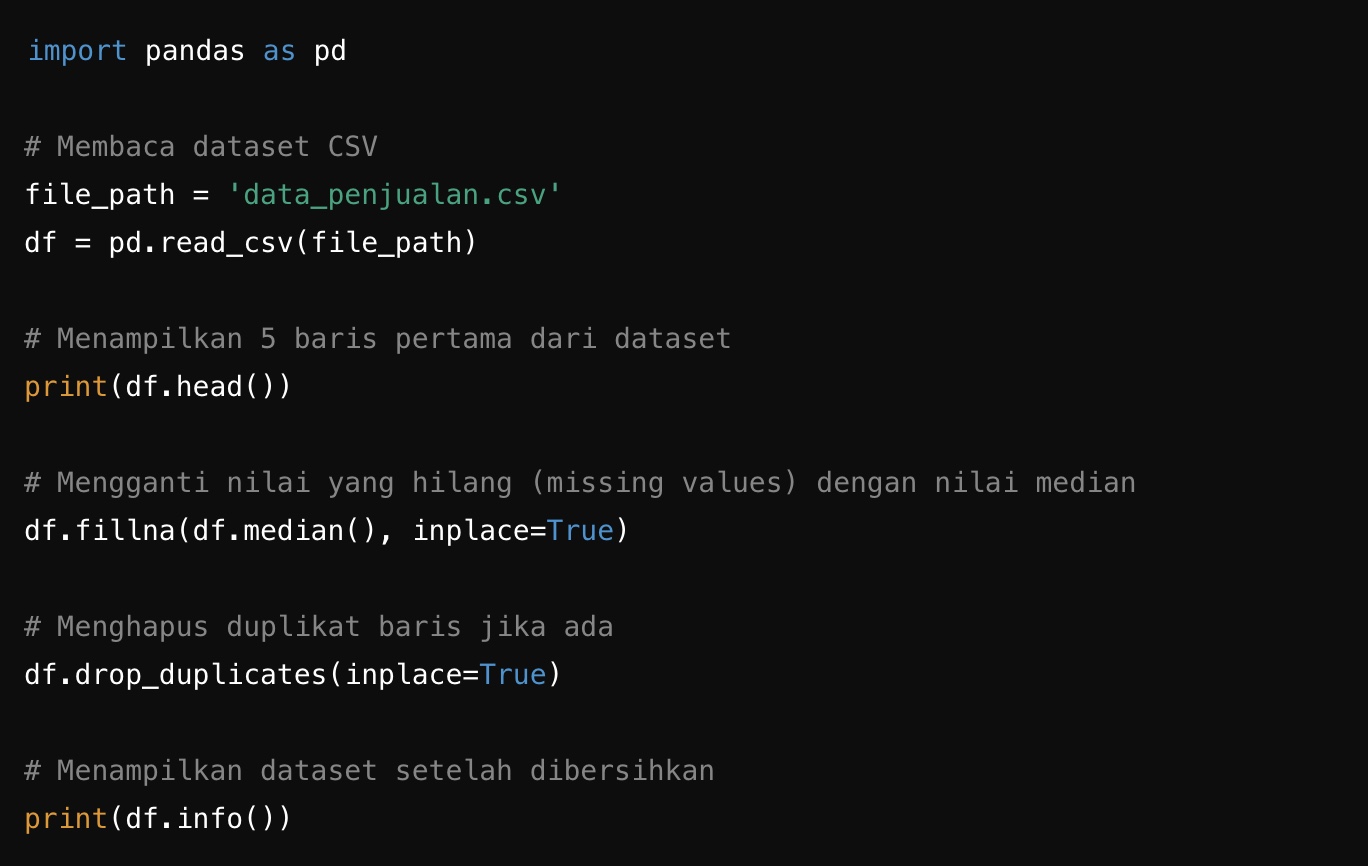

Langkah pertama dalam mengolah data adalah membaca dataset dan membersihkannya dari nilai-nilai yang hilang atau tidak valid. Berikut adalah contoh skrip sederhana untuk membaca dan membersihkan dataset menggunakan Pandas:

Pada skrip di atas, kita membaca file CSV menggunakan pd.read_csv() dari library Pandas. Selanjutnya, kita membersihkan data dengan:

Mengisi nilai yang hilang dengan nilai median dari kolom terkait (fillna()).

Menghapus baris yang duplikat dengan fungsi drop_duplicates().

Proses membersihkan data ini sangat penting agar analisis berikutnya menjadi lebih akurat dan tidak terpengaruh oleh data yang rusak atau hilang.

5. Langkah 3: Pengolahan Data dengan Python

Setelah dataset dibersihkan, kita bisa mulai melakukan pengolahan data. Dalam konteks Big Data, pengolahan data melibatkan berbagai teknik seperti filtering, grouping, dan aggregating untuk mendapatkan informasi yang lebih bermakna.

Untuk dataset besar, library seperti PySpark juga sangat berguna karena mampu menangani data dalam skala besar secara paralel.

Mari kita mulai dengan pengolahan sederhana menggunakan Pandas, dan untuk data yang lebih besar, kita akan melihat cara memprosesnya dengan PySpark.

Pengolahan Data dengan Pandas

Misalkan kita ingin menganalisis total penjualan per kategori produk. Kita bisa melakukan operasi berikut:

Dalam skrip di atas, kita menggunakan metode groupby() dari Pandas untuk mengelompokkan data berdasarkan kolom category dan menjumlahkan penjualan (sales). Fungsi agg() memungkinkan kita untuk melakukan agregasi, dalam hal ini menjumlahkan total penjualan.

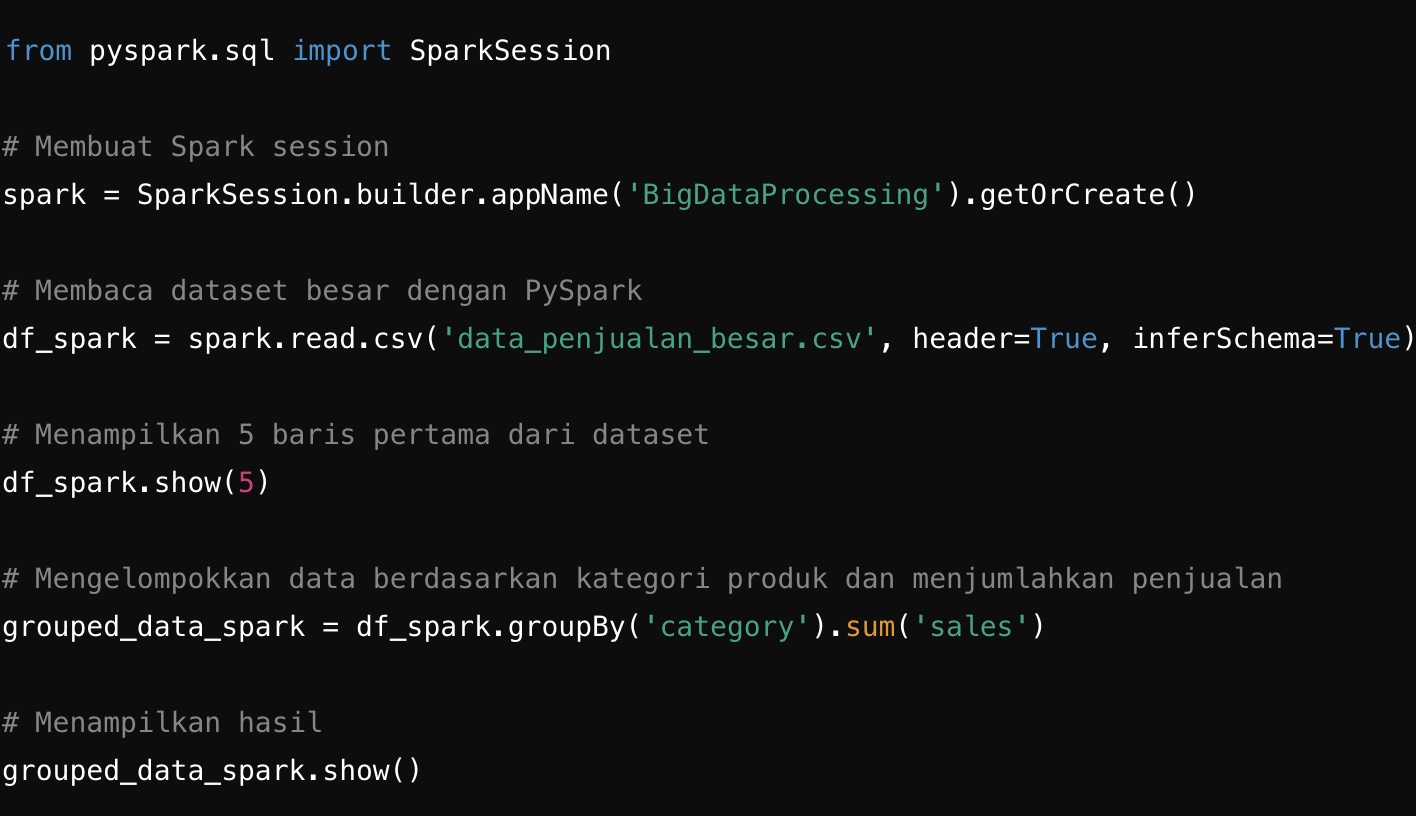

Pengolahan Data dalam Skala Besar dengan PySpark

Jika dataset sangat besar sehingga Pandas tidak mampu menanganinya dengan efisien, kamu bisa beralih ke PySpark. PySpark adalah versi Python dari Apache Spark yang memungkinkan pemrosesan data secara parallel dan terdistribusi. Berikut adalah contoh bagaimana memproses data dengan PySpark:

Pada contoh ini, kita menggunakan SparkSession untuk memulai sesi PySpark. PySpark lebih cocok untuk memproses dataset yang lebih besar dari kapasitas RAM karena ia membagi pekerjaan ke berbagai komputer atau core CPU, sehingga mempercepat pemrosesan data.

Kamu bisa melihat bahwa meskipun struktur kode antara Pandas dan PySpark sedikit berbeda, konsep dasarnya tetap sama. Hal ini memudahkan kamu untuk berpindah antara Pandas dan PySpark tergantung pada ukuran dataset yang kamu tangani.

Baca juga : Bootcamp Data Analyst with SQL and Python

5. Langkah 4: Visualisasi Data untuk Insights

Setelah data selesai diolah, langkah berikutnya adalah visualisasi untuk mendapatkan insights yang lebih mudah dipahami. Visualisasi data adalah cara yang sangat efektif untuk menyampaikan informasi dari data besar. Python menyediakan beberapa library visualisasi seperti Matplotlib, Seaborn, dan Plotly.

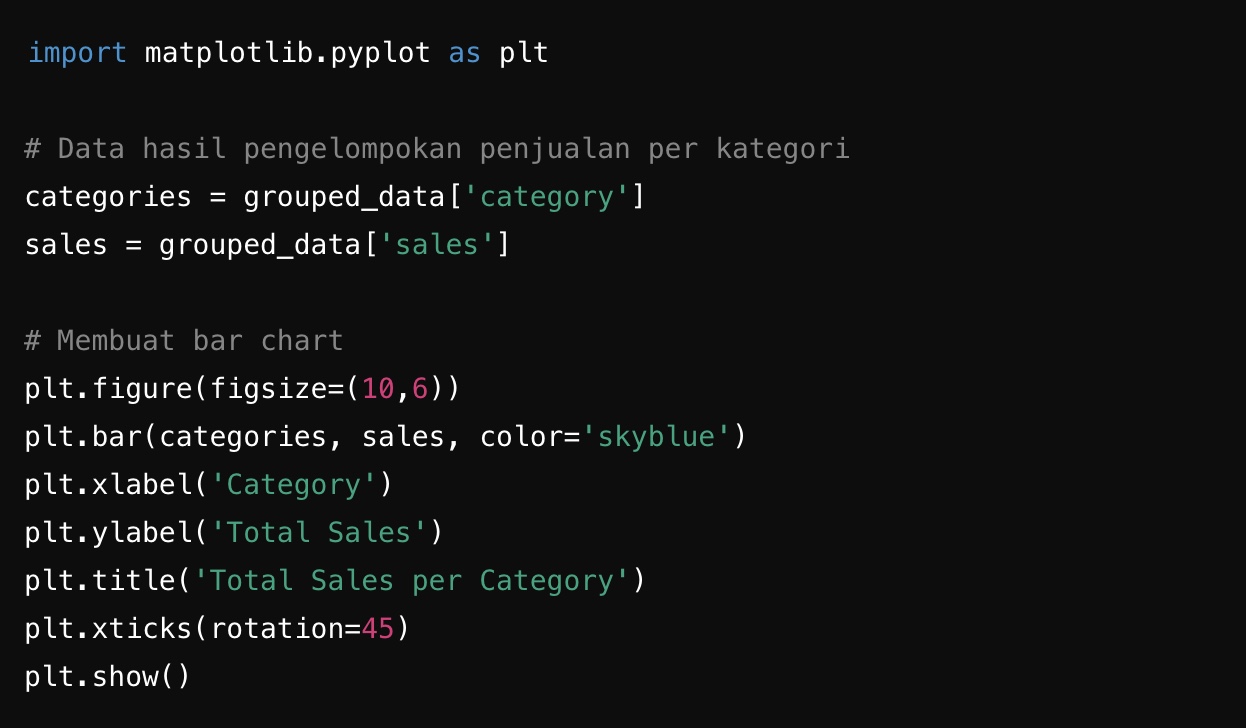

Mari kita mulai dengan contoh sederhana menggunakan Matplotlib untuk membuat grafik total penjualan per kategori.

Contoh Visualisasi dengan Matplotlib

Dalam contoh ini, kita menggunakan plt.bar() dari Matplotlib untuk membuat bar chart yang menunjukkan total penjualan per kategori. Fungsi plt.xticks() digunakan untuk memutar label kategori agar lebih mudah dibaca.

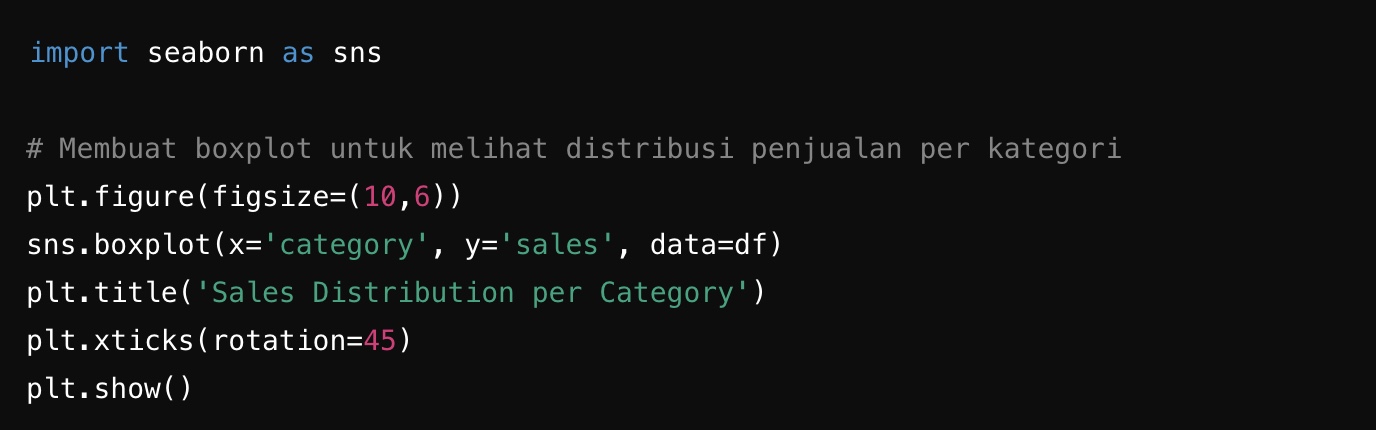

Visualisasi dengan Seaborn untuk Insights Lebih Mendalam

Seaborn adalah library visualisasi yang dibangun di atas Matplotlib dengan kemampuan membuat grafik yang lebih kompleks secara sederhana. Misalnya, jika kita ingin melihat distribusi penjualan per kategori menggunakan grafik boxplot, kita bisa melakukannya dengan mudah menggunakan Seaborn:

Pada contoh ini, boxplot akan menunjukkan distribusi penjualan di setiap kategori produk. Grafik ini sangat berguna untuk memahami rentang nilai, outlier, dan median dari data.

Gimana? Kamu ingin mahir menguasai keterampilan untuk menggunakan Python di era Big Data, tapi bingung harus mulai dari mana? Jangan khawatir! Segera Sign Up ke DQLab! Di sini, kamu bisa belajar dari dasar hingga tingkat lanjut dengan materi dan tools yang relevan dengan kebutuhan industri, bahkan tanpa latar belakang IT. Belajar kapan saja dan di mana saja dengan fleksibilitas penuh, serta didukung oleh fitur eksklusif Ask AI Chatbot 24 jam!

DQLab juga menyediakan modul berkualitas yang disusun oleh para ahli dengan studi kasus yang bisa membantu kamu memahami cara memecahkan masalah nyata dari berbagai industri. Tak hanya itu, metode pembelajaran HERO (Hands-On, Experiential Learning & Outcome-based) yang diterapkan, ramah untuk pemula dan telah terbukti mencetak talenta-talenta unggulan yang sukses berkarier di bidang data.

Jadi, tunggu apa lagi? Segera persiapkan diri untuk menguasai keterampilan di bidang data dan teknologi dengan subscribe modul premium, atau ikuti Bootcamp Data Analyst with SQL and Python sekarang juga!

Penulis: Lisya Zuliasyari

Postingan Terkait

Menangkan Kompetisi Bisnis dengan Machine Learning

Mulai Karier

sebagai Praktisi

Data Bersama

DQLab

Daftar sekarang dan ambil langkah

pertamamu untuk mengenal

Data Science.

Daftar Gratis & Mulai Belajar

Mulai perjalanan karier datamu bersama DQLab

Sudah punya akun? Kamu bisa Sign in disini